信赖各位站长都知道你的网站中有robots文件,但他的作用有哪些?照旧有些站长一孔之见的,接下来篇章教大家robots怎么用。

一、我们一个新站假如没把站内布局做完,可以用robots文件设置禁止搜索引擎抓取访问,它禁止悉数蜘蛛爬行的语法是:

User-agent: *

Disallow: /

假如你想禁止个别搜索引擎蜘蛛,我拿谷歌的举例:

User-agent: Googlebot

Disallow: /

按理说我们设置了禁止如许蜘蛛就不会爬行了百度关键词排名,然而事实真是如许吗?

篇章的答案是否定的。请看案例(以百度蜘蛛为例)

大家在百度搜索“淘宝”就能看到了,截图:

效果表现:“因为该网站的robots.txt文件存在限定指令(限定搜索引擎抓取),体系无法提供该页面的内容描述”

而且是可以访问百度网站排名,(ps:这个是大的网站是特别例外,笔者也想过之前做过查证,而且确实有如许的网站,只是在偶然中看到的当时没有记录,实在抱歉今天再找却记不起来了)

应用:新网站测试,站长心想没有提交蜘蛛应该不会被收录,谁知被奇妙的收录了(ps:可怜的qq临时会话优化策略没有上马,就如许跟百度蜘蛛相逢了)之后采取robots屏蔽发现这些必要时间不能达到预期结果,网站被竞争者窃取,因为时间紧急的缘故原由,最后是关闭服务器提交死链才消弭百度搜索收录记录。

2、robots.txt具有屏蔽死链接的作用,提交后会不会立马这些死链接会消散收录?

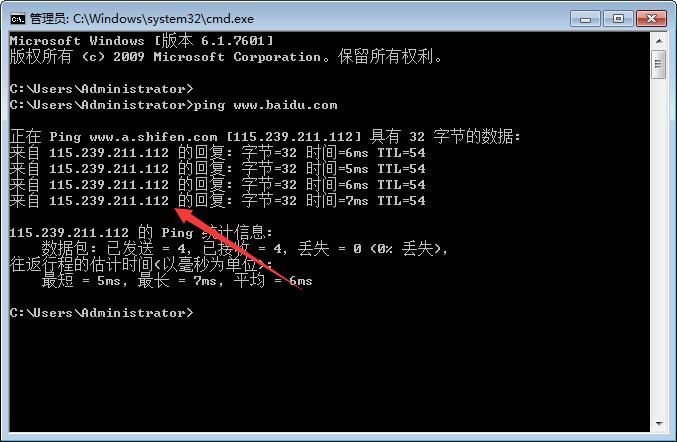

篇章的答案是否定的,由于我们都知道百度在各个省都有各个百度的服务器,因此不可能同时清楚缓存,为此我们可以ping一下百度。

操作过程:

一、打开体系的运行,快捷键是“WIN+R”

二、输入ping-空格-百度域名-最后回车

操作完我们会看到如许的:

我本地是上海的IP四川人事考试信息网,它表现的是115.239.211.112 各位的IP一定跟我不一样,因此验证了我上面所说。

不过想快速消散死链百度站长平台倒是有一个“死链提交”的功能,大家可以去看看,那是快速消灭死链的方法,前些天试了一下,还挺好用,很快就能得到相应:

不知道大家看完后有什么想说的,都可以在评论区评论一下,篇章会尽心回复的。

qq弹出聊天窗口SEO篇章(www.esmo.cn/SEOpz3564)语录:再牛逼的qq临时会话优化技术 也拼不过冒着傻气的坚持。